Docker 大数据环境搭建

引言

在现代软件开发和数据科学领域,大数据环境的搭建是必不可少的一环,利用 Docker 容器化技术可以轻松地创建隔离、可复制的大数据环境,本文将详细介绍如何使用 Docker 搭建一个包含 Hadoop、Spark 等组件的大数据环境。

准备工作

在开始之前,确保系统满足以下条件:

1、安装了 Docker 和 Docker Compose。

2、足够的磁盘空间来存放大数据文件。

3、基础的 Linux 操作知识。

环境规划

为了搭建一个功能完整的大数据环境,我们需要考虑以下几个核心组件:

Hadoop: 分布式存储和处理框架。

Spark: 高速大数据处理引擎。

Zookeeper: 提供分布式协调服务。

Hive: 数据仓库工具,运行于 Hadoop 之上。

Hue: 提供 Web 界面的 Hive 和 Beeline 的监控工具。

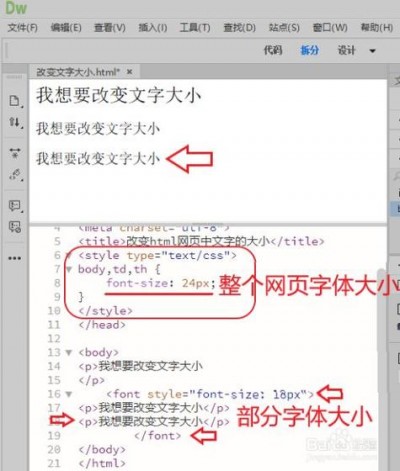

Dockerfile 编写

我们需要为每个服务创建一个 Dockerfile,以下是 Hadoop 的 Dockerfile 示例:

使用官方的 Hadoop 镜像作为基础 FROM apache/hadoop2.7.3 设置必要的环境变量 ENV HADOOP_HOME=/usr/local/hadoop ENV PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin 暴露需要的端口 EXPOSE 50070 9000类似地,可以为 Spark、Zookeeper、Hive 和 Hue 创建各自的 Dockerfile。

dockercompose.yml 配置

接下来,我们需要使用 Docker Compose 来定义服务之间的依赖关系以及如何运行它们,以下是一个简化版的 dockercompose.yml 配置文件:

version: 3 services: hadoop: build: ./hadoop volumes: hadoopdata:/hadoop/hdfs/namenode ports: "9000:9000" "50070:50070" environment: CLUSTER_NAME=TestCluster spark: build: ./spark ports: "4040:4040" depends_on: hadoop environment: SPARK_MASTER_HOST=hadoop SPARK_MASTER_PORT=7077 SPARK_EXECUTOR_MEMORY=2g volumes: hadoopdata:这个文件定义了两个服务:Hadoop 和 Spark,以及它们之间的依赖关系,它还映射了 Hadoop 的 HDFS 到宿主机的卷,以便持久化数据。

环境启动与验证

使用 Docker Compose,可以通过简单的命令启动整个大数据环境:

dockercompose up d启动后,可以通过浏览器访问 Hue 的 Web 界面(通常位于 http://localhost:8080),并使用默认的用户名和密码登录,进行 Hive 和 Beeline 的操作。

性能优化

在实际环境中,可能需要根据工作负载对环境进行调优,比如调整 Hadoop 和 Spark 的配置参数,增加节点数量等。

相关问答 FAQs

Q1: 如何扩展 Hadoop 集群以增加存储容量?

A1: 可以通过在 dockercompose.yml 文件中添加更多的 Hadoop 节点来实现,每个节点都需要映射到独立的磁盘卷上,以确保数据分布。

Q2: 我的数据不在 HDFS 中,我应该如何将其迁移进去?

A2: 你可以使用 Hadoop 的文件传输工具 distcp 或 Hadoop 文件系统的命令 put 和 get 来在本地文件系统和 HDFS 之间移动数据。

上文归纳

通过上述步骤,我们已经成功搭建了一个基于 Docker 的大数据环境,这样的环境可以用于开发、测试甚至是生产环境,具有很高的灵活性和可扩展性。