近日,上海人工智能实验室(上海 AI 实验室)发布新一代高质量大模型预训练语料“万卷 CC”(WanJuan-CC),首批开源的语料覆盖过去十年互联网上的公开内容,包含 1 千亿字符(100Btoken),约 400GB 的高质量英文数据。作为“大模型语料数据联盟”今年首发的开源语料,WanJuan-CC 将为学界和业界提供大规模、高质量的数据支撑,助力构建更智能可靠的 AI 大模型。

预训练数据的质量对大模型整体性能至关重要。当前,CommonCrawl(CC)数据集因其规模大、跨度广而成为国际主流大模型训练数据的重要来源。与此同时,其原始数据格式复杂、数据质量低等问题,或将导致模型训练效率低,甚至可能引发价值观对齐等方面的隐患。

中国科研人员通过原创的数据清洗技术,从 CC 数据库中抽取约 1300 亿份原始数据文档进行再处理,“萃取”出其中约 1.38% 的高质量内容,构建成 WanJuan-CC 语料库。实验结果显示,WanJuanCC 具有高文本质量、高信息密度的特点,可满足当前大模型训练对大规模高质量语料的需求。

上海 AI 实验室发布的书⽣·浦语 2.0(InternLM2)即以 WanJuan-CC 为关键数据作支撑,使训练效率和语言建模能力大幅提升,综合性能领先开源社区。

开源数据:https://opendatalab.com/OpenDataLab/WanJuanCC

高质量语料驱动,效率性能双提升

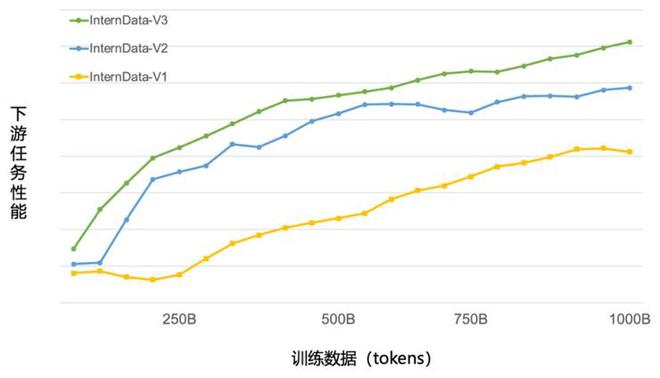

近期,上海 AI 实验室发布了新一代大语言模型书⽣·浦语 2.0(InternLM2)。回归语言建模本质,InternLM2 综合性能达到同量级开源模型的领先水平。模型基座语言建模能力的提升,则得益于预训练文本质量及信息密度的增强。作为 InternLM2 的关键预训练语料,WanJuan-CC 的文本质量和高信息密度经过了模型实际验证。在 InternLM2 的训练过程中,在仅使用约 60% 的训练数据情况下,模型即获得了与此前使用 1T token 相同的性能表现,大幅提升训练效率,并使模型在相同语料规模上取得了更好的性能。

绿色曲线为 InternLM2 使用 WanJuan-cc 作为预训练语料,在不同数据规模上取得的任务性能分布,结果显示,WanJuan-CC 可大幅提升模型训练效率

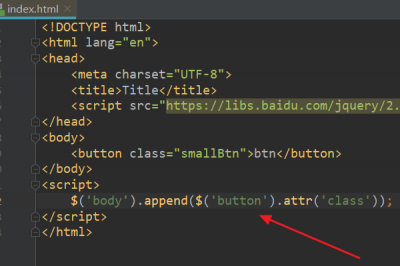

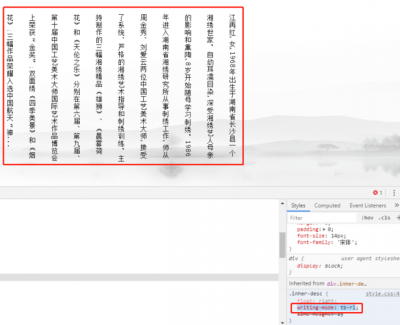

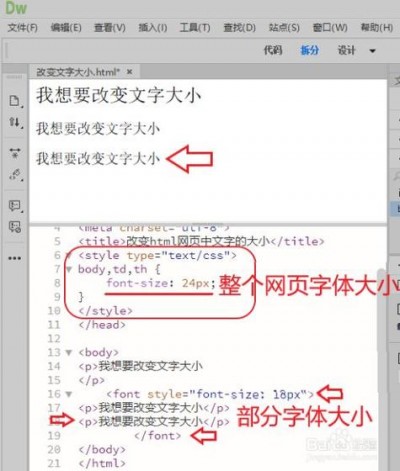

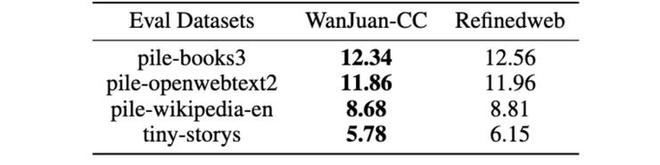

研究团队通过对 CC 原始数据进行清洗,去除了网页代码和重复内容,同时利用分类模型剔除了广告和质量较差的信息,并通过内容一致性、语法正确性、数据噪声和信息价值等四个维度,对语言的流畅性进行评估。为验证数据质量,研究团队使用 WanJuan-CC 和 RefineWeb(从 CommonCrawl 中抽取并构建的主流英文预训练语料)分别重新训练了参数量 1B 的模型,并进行评测。结果显示,由 WanJuan-CC 作为训练数据的模型在多项验证中取得了更优效果。

基于 WanJuan-CC 训练的 1B 模型在 Pile 验证集评测效果更优,这表明由 WanJuan-CC 训练的模型在不同领域和各类知识上拥有更强能力

四重处理,百里挑一“萃取”高质量数据

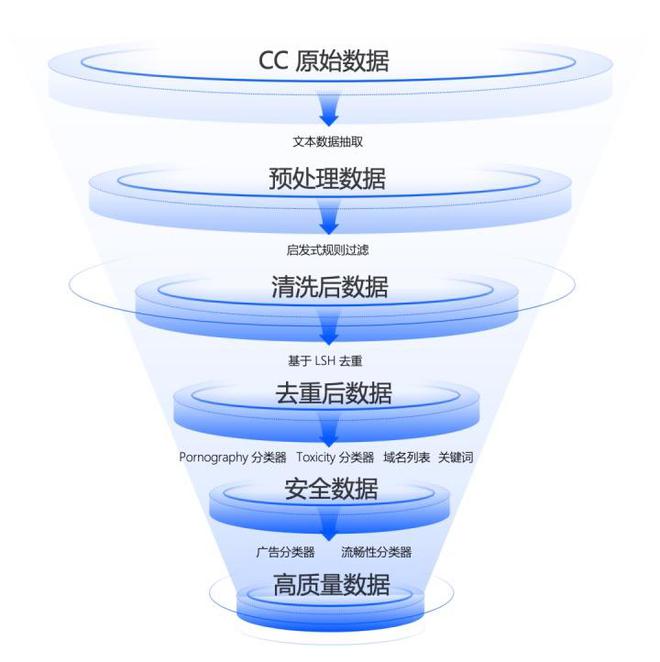

为从浩如烟海的 CC 数据库中“精选”最可靠的信息,研究团队搭建了高性能分布式数据处理基础设施,通过启发式规则过滤、多层级数据去重、内容安全过滤、数据质量过滤等四个步骤,从原始数据中“萃取”出高质量数据,数据留存率仅为原数据的 1.38%。

通过原创技术,对 CC 原始数据进行多阶段处理,得到了高信息密度的 WanJuan-CC

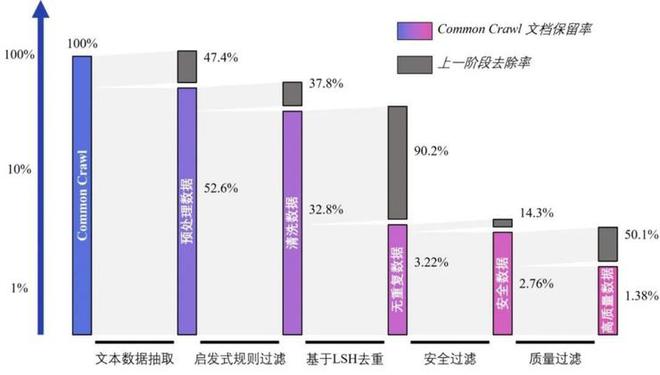

研究团队首先从 CC 中抽取了约 1300 亿份原始数据文档,然后基于高性能数据处理工作流得到 2.2T token(35.8 亿个文档)安全数据,最后,根据质量排序精选出 1T token(3.6 亿个文档)质量最高的数据,构建成 WanJuan-CC。如以下柱状图所示,在 WanJuan-CC 构建过程中的每一阶段,均进行了大比例的数据去除。对于仅占原 CC 数据比例 2.76% 的安全信息,研究人员再次“筛”掉五成低质内容,最终呈现出“百里挑一”的高质量数据。

各清洗阶段的文档保留率和去除率(本图使用对数坐标轴)

数据质量高,模型更可靠

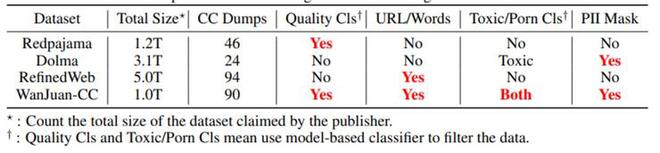

为推动训练更智能可靠的 AI 大模型,研究团队以保障数据安全性为前提,在数据处理的各环节均实施了多项安全加固措施,使 WanJuan-CC 成为目前开源 CC 语料中首个在毒性(Toxic)、色情(Porn)和个人隐私三方面同时进行了安全加固的英文语料,因而在价值对齐方面具有更高的可靠性。

与部分开源 CC 语料多维度对比,在毒性、色情和个人隐私等方面,WanJuan-CC 均进行了安全加固

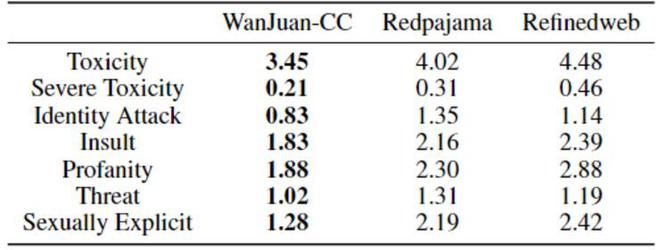

研究人员分别对 WanJuan-CC、Redpajama 和 Refineweb 数据集进行了 10 万条数据的抽样,从毒性、侮辱、恐吓等 7 个维度进行评分,以验证各数据集的信息安全性。结果显示,WanJuan-CC 在各维度上的体现出最高安全性。

WanJuan-CC 与其他开源英文 CC 语料安全性对比

高质量、多模态、宽领域的数据已成为支持当前人工智能大模型发展的重要基石。WanJuan-CC 的主要构建团队——OpenDataLab 致力于建设面向人工智能开发者的超大规模、高质量、多模态开放数据服务平台,目前已汇聚高质量多模态数据集超 6500 个,涵盖大模型研发应用所需的各类语料数据。雷峰网雷峰网雷峰网

下载更多开源语料,请登录大模型语料数据联盟开源数据服务指定平台: