出品丨网易科技《态度》

作者丨赵芙瑶

编辑丨丁广胜

皮衣教主又杀回来了!

在今日的英伟达 GTC(GPU 技术大会)上,黄仁勋再次炸场,每个产品的发布与更新都让现场掌声连连。英伟达新一代 Blackwell 架构来了;“一个顶五个”的 B200 来了;“让全世界用上 AI”的 AI 推理微服务 NIM 也来了!让我们一起来回顾这一场吸引全球目光、号称标志着“新工业革命”引擎诞生的发布会。

1. 黄仁勋:新时代的乔布斯

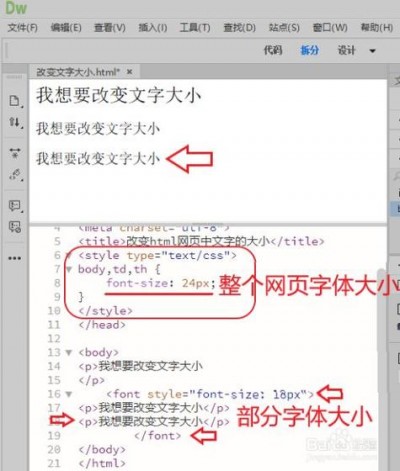

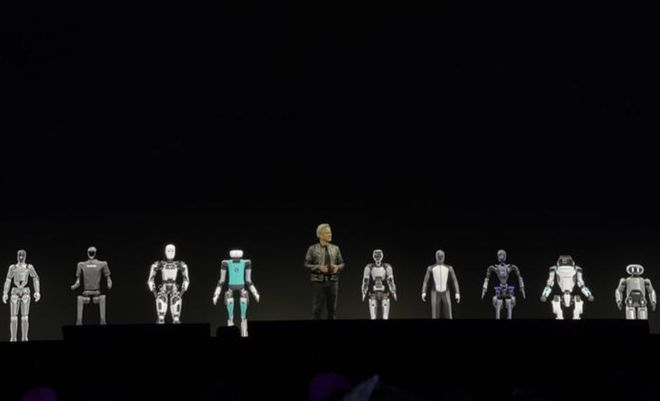

有了生成式 AI 的加持,黄仁勋此次的演讲像是一场科幻电影,无论是现场播放的由 Backwell 制作的影像片段,还是黄教主现场与九个机器人的互动,都让现场的科技感、沉浸感、未来感直线拉满。

去年黄仁勋喊出 AI 的“iPhone 时刻”已经到来,生成式 AI 不断开始改写我们的日常生活,而今天的一系列发布,更是表明改写的速度正在指数级上升。

英伟达高级科学家 Jim Fan 现场调侃黄仁勋是新的泰勒 · 斯威夫特,因为现场人满为患如演唱会一般,然而黄教主用两个小时的时间,让观众明白了或许他才是新时代的乔布斯。

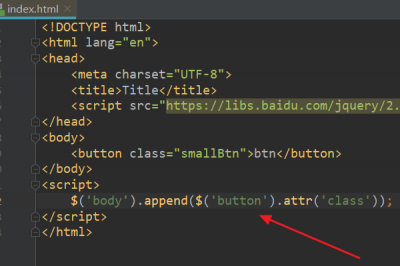

2. 性能翻 30 倍的世界最强 GPU 来了

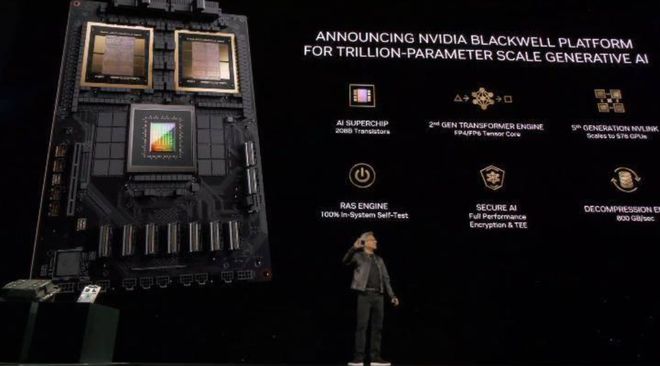

黄教主带来了第一张王牌就是 Blackwell 架构,黄仁勋称这颗芯片的名字来自数学家、博弈论家、概率论家 David Blackwell。基于 Blackwell 架构的 Blackwell B200 GPU 在性能上翻了 30 倍,带来了惊人的计算能力。

Blackwell 架构下的计算芯片拥有 1040 亿个晶体管,比上一代 GH100 GPU 的 800 亿个晶体管实现了重大突破。而且,Blackwell B200 并非传统意义上的单一 GPU,而是由两个 Blackwell GPU 组合而成。通过 10 TB/s NV-HBI(Nvidia 高带宽接口)连接,确保每个芯片都能独立运行。

因此,B200 实际上拥有 2080 亿个晶体管,能够提供高达 20 petaflops 的 FP4 算力。其中,两个 GPU 与单个 Grace CPU 相结合的 GB200 可将 LLM(大语言模型)的推理效率提升 30 倍。

在 GPT-3 LLM 基准测试中,GB200 的性能是 H100 的七倍,训练速度提高了 4 倍。第二代 Transformer 引擎、第五代 NVLink 高速互联、Ras Engine 等技术的引入,更是让英伟达的产品在 AI 计算领域更加“所向披靡”。

3. GB200 超级芯片:创造历史的推理加速

GB200 超级芯片是两个 B200 GPU 与 Grace CPU 结合的产品,成为推理加速的新“核弹”。它不仅可以加速推理,同时在成本和能源消耗上也实现了突破。

黄仁勋在现场介绍道,B200 采用双芯片设计,晶体管数量达到 2080 亿个,单 GPU AI 性能达 20 PFLOPS。两个 B200 GPU 与 Grace CPU 结合组成最强 AI 芯片 GB200,通过 900GB/s的超低功耗 NVLink 芯片间互连技术连接。在标准的 1750 亿参数 GPT-3 基准测试中,GB200 的性能是 H100 的 7 倍,提供的训练算力是 H100 的 4 倍。

另外,英伟达此次还带来了全新加速计算平台 DGX GB200 NVL72,搭载 18 个 GB200,单机架即可达到每秒千万亿次级别的精度计算。相比 72 个 H100,GB200 NVL72 推理性能提升 30 倍,成本和能耗降低 25 倍。一个 GB200 NVL72 机柜可训练 27 万亿参数的模型,足以支持 15 个 GPT-4 模型。

黄仁勋表示,DGX Grace-Blackwell GB200 已经超过 1 Exaflop 的算力。这意味着什么呢?

让我们通过一个简单的比喻来说明其水平:

假设你有一台普通的笔记本电脑,它的算力是 1 Gigaflop(即每秒 10 的 9 次浮点运算)。如果你的笔记本电脑每秒能够完成 1 次浮点运算,那么完成 10^18(即 1 Exaflop)次浮点运算需要多长时间呢?

1 Exaflop = 10^18 Flops

如果你的笔记本电脑每秒完成 1 Flop,那么完成 10^18 Flops 就需要:

(10^18 Flops) / (1 Flop/second) = 10^18 seconds

换算成年份:

10^18 seconds / (60 seconds/minute * 60 minutes/hour * 24 hours/day * 365 days/year) ≈ 31.7 亿年

换句话说,一台每秒完成 1 Flop 的笔记本电脑,要花费大约 31.7 亿年的时间才能完成 1 Exaflop 的运算量。

所以 1 Exaflop 的庞大程度,可以说是一鸣惊人了。

4. 推理微服务 NIM:AI 部署的新标杆

NVIDIA 推出的 AI 推理微服务 NIM 成为世界 AI 的入口,为用户提供了部署和管理 AI 模型的平台。通过 NIM,用户可以体验各种 AI 模型和应用,同时保留对知识产权的完全控制。黄仁勋表示,NVIDIA 正在帮助企业和应用程序对模型进行微调或定制。

NIM 可以使开发者能够将部署时间从几周缩短至几分钟,为语言、语音、药物发现等领域提供行业标准 API,让开发者能够利用在自己基础设施中的专有数据快速构建 AI 应用,而不必依赖云服务器。

英伟达希望通过这些服务吸引购买英伟达服务器的客户注册英伟达企业版 NVIDIA AI Enterprise 5.0,每个 GPU 每年收取 4500 美元的费用。企业可以选择在亚马逊云科技(AWS)、谷歌云、Azure、Oracle Cloud Infrastructure 等云平台上部署这些微服务。

相较于新 AI 模型的初始训练,推理过程所需的计算能力较少。对于那些希望自行运行 AI 模型,而不是购买 AI 结果作为服务的企业来说,NIM 将成为一款不错的选择。

“在我原本调用 OpenAI 的代码中,我只需替换一行代码,将其指向从英伟达获取的 NIM 即可。”一位开发者表示。

5. 英伟达的愿景:引领新工业革命

黄仁勋的野心究竟有多大?在他看来,英伟达站在计算科学和物理等一切科学的交叉点,成为新工业革命的引擎。这是英伟达的使命,也是他心中英伟达的定位。

正如黄仁勋在开场白中说的那样,我们见证了计算机技术的革命以及人工智能的崛起。从过去到现在,我们经历了无数里程碑,包括首台 DGX-1 超级计算机的诞生、CUDA 的出现以及生成式 AI 的发展。

如今,皮衣教主黄仁勋已经在生成式 AI 领域拔得头筹,带领着下一场工业革命的开启。

相关阅读:

性能可提升 30 倍,英伟达发布全新构架,今年上市,一套或售 20 万美元

3 月 19 日消息,当地时间周一,英伟达在美国加州圣何塞(San Jose)举办的全球开发者大会上,隆重发布了最新一代人工智能专用 GPU 芯片以及运行人工智能模型的软件,意图进一步巩固其作为人工智能领域首选供应商的地位。

英伟达推出的新一代人工智能 GPU 架构命名为 Blackwell,首款基于该架构的 GB200 芯片预计将在今年晚些时候推出。

在处理大型语言模型(LLM)推理工作负载时,GB200 性能可提升 30 倍,同时在成本和能效上也有显著提升。英伟达称,与 H100 相比,“GB200 能将成本和能耗降低至多达 25 倍”。

尽管当前市面上如 Hopper 架构的 H100 芯片等旧款产品依然供不应求,英伟达仍通过推出更高性能的新芯片来吸引客户,鼓励他们持续下单。

自 2022 年底,随着 OpenAI 推出聊天机器人 ChatGPT,掀起了一股人工智能热潮,英伟达股价随之飙升五倍,营业收入也增长了逾两倍。英伟达的高性能 GPU 对于训练和运行大型人工智能模型至关重要。像微软、Meta 这样的科技巨头,都斥资几十亿美元购买这种芯片。英伟达首席执行官黄仁勋在大会上表示:“Hopper 架构固然出色,但我们追求的是更加强大的 GPU。”

英伟达股价在周一盘后交易中微跌超过1%。

为了让客户在面对日益增多的竞争产品时更倾向于选择英伟达芯片,公司还推出了一款名为 NIM 的付费软件,使得部署人工智能变得更加简单。

英伟达高管表示,公司正从单一芯片供应商转型为类似于微软或苹果那样的平台提供者,其他公司可以在其平台上开发软件。

黄仁勋坦言:“Blackwell 不仅仅是一款芯片,它代表的是一个平台。”

英伟达企业计算部门副总裁马努维尔·达斯(Manuvir Das)在接受采访时表示:“最畅销的商业产品仍是 GPU,软件则是为了帮助用户以不同的方式使用 GPU。”他补充道:“当然,我们依然在致力于产品的创新。但现在,我们真正实现了转变,已经发展出了自己的商业软件业务。”

英伟达新软件能让在所有英伟达 GPU 上运行程序变得更加简便,即便是对于那些老款 GPU,它们虽更适合于部署人工智能应用,而非开发,也能轻松应对。

达斯说:“如果您是开发者,手中有一个备受期待的模型,希望能让更多人采用,只需将其部署在 NIM 上。我们承诺将兼容所有英伟达 GPU,确保模型能触及广泛用户群。”

Hopper 架构的继任者 Blackwell

每隔两年,英伟达都会更新其 GPU 架构,从而实现性能的显著跃升。在过去一年中,众多发布的人工智能模型均在 2022 年宣布的 Hopper 架构基础上进行训练,此架构涵盖了包括 H100 在内的多款芯片。

据英伟达介绍,基于 Blackwell 架构的 GB200 芯片将为人工智能领域公司带来性能上巨大的飞跃,其人工智能计算能力可达每秒 20 千万亿次,远超过 H100 芯片的每秒 4 千万亿次。

这一强大的计算能力将使企业得以训练规模更大、复杂度更高的人工智能模型。

GB200 芯片还特别集成了英伟达的高性能 Transformer 推理引擎,该技术专为运行基于 Transformer 架构的人工智能设计,正是构成流行聊天机器人 ChatGPT 核心技术的关键部分。

Blackwell 架构的 GPU 芯片体积庞大,实际上是由两块独立制造的芯片集成于一块台积电代工的芯片上。英伟达同时推出了配套的 GB200 NVLink 2 服务器,内置 72 块 Blackwell 架构 GPU,以及其他用于人工智能模型训练的专业组件。

知名云服务提供商,包括亚马逊、谷歌、微软及甲骨文等,均将提供 GB200 芯片的云服务。每套 GB200 系统由两块基于 Blackwell 架构的 B200 GPU 和一块基于 ARM 架构的 Grace CPU 组成。英伟达透露,亚马逊网络服务(AWS)计划建立一个包含 2 万套 GB200 系统的超级计算集群。

英伟达表示,亚马逊的服务器集群能够部署达到 27 万亿个参数的人工智能模型,规模远超目前已知最大的 GPT-4 模型,后者拥有 1.7 万亿个参数。许多人工智能研究人员认为,拥有更多参数和数据的超大模型能够展现出更为强大的能力。

虽然英伟达未公布 GB200 芯片及其系统的具体售价,但根据分析师估计,参照 Hopper 架构 H100 芯片的售价范围(每块约 2.5 万至 4 万美元),一整套 GB200 系统的成本可能高达 20 万美元。

英伟达的推理微服务

英伟达还宣布,在其企业软件订阅服务中新增了一款名为 NIM 的产品,即英伟达推理微服务(NVIDIA Inference Microservices)的缩写,旨在简化使用旧型号 GPU 进行人工智能推理和软件运行的过程,使企业能够继续利用现有的数亿块英伟达 GPU 资源。相较于训练新的人工智能模型,推理计算所需的计算资源更少,因此,企业可以通过 NIM 更加便捷地运行自己的人工智能模型,而不必依赖于 OpenAI 等公司提供的计算服务。

作为其战略的一部分,英伟达鼓励购买其服务器的客户订阅英伟达企业服务,并按每块 GPU 每年 4500 美元的标准收取许可费。此外,英伟达将与微软、Hugging Face 等领先的人工智能企业合作,确保它们开发的人工智能模型能够在所有兼容的英伟达芯片上顺畅运行。开发者可通过 NIM 服务,无需复杂配置,就能在自己的服务器或基于云的英伟达服务器上高效地运行模型。

“在原本调用 OpenAI 服务的代码中,仅需替换一行代码,即可将其连接至英伟达提供的 NIM 服务,”达斯解释说。

英伟达表示, NIM 软件不仅能在云服务器上运行,还能使配备英伟达 GPU 的笔记本电脑上顺畅运行人工智能应用,进一步扩展了 NIM 服务的应用场景。(辰辰)