新智元报道

编辑:Aeneas 好困

昨晚的 Google Cloud Next 2024 大会上,谷歌接连放出一堆模型和产品王炸:Gemini 1.5 Pro 公开可用、上线音频处理能力;代码模型 CodeGemma 上新,首款自研 Arm 处理器 Axion 正式向微软和亚马逊宣战……这次,谷歌要以量取胜。

昨天的谷歌 Next 大会可是太精彩了,谷歌一连放出不少炸弹。

- 升级「视频版」Imagen 2.0,下场 AI 视频模型大混战

- 发布时被 Sora 光环掩盖的 Gemini 1.5 Pro,正式开放

- 首款 Arm 架构 CPU 发布,全面对垒微软/亚马逊/英伟达/英特尔

此外,谷歌的 AI 超算平台也进行了一系列重大升级——最强 TPU v5p 上线、升级软件存储,以及更灵活的消费模式,都让谷歌云在 AI 领域的竞争力进一步提升。

连放大招的谷歌,必不会在这场 AI 大战中退让。

从 OpenAI 跳槽的研究员 Logan Kilpatrick,也在第一时间转发了 Gemini 1.5 Pro 的消息。看得出来,他已经是一名真真正正的谷歌员工了

在短短两个月内,谷歌一键将多种前沿模型引入 Vertex AI,包括自家的 Gemini 1.0 Pro、轻量级开源模型 Gemma,以及 Anthropic 的 Claude 3。

Gemini 1.5 Pro,人人可用了!

传说中的谷歌最强杀器 Gemini 1.5 Pro,已经在 Vertex AI 上开放公测了!

开发者们终于可以亲自体验到,前所未有的最长上下文窗口是什么感觉。

Gemini 1.5 Pro 的 100 万 token,比 Claude 3 中最大的 200K 上下文,直接高出了五倍!而 GPT-4 Turbo,上下文也只有 128K。

当然,超长上下文在无缝处理输入信息方面,仍然有一定的局限性。

但无论如何,它让对大量数据进行本机多模态推理成为可能。从此,多海量的数据,都可以进行全面、多角度的分析。

自然而然地,我们可以正式用 Gemini 1.5 Pro 开发新的用例了。比如 AI 驱动的客户服务智能体和在线学术导师,分析复杂的金融文件,发现文档中的遗漏,查询整个代码库,或者自然语言数据集。

现在,已经有无数企业用 Gemini 1.5 Pro 真实地改变了自己的工作流。

比如,软件供应商思爱普用它来为客户提供与业务相关的 AI 解决方案;日本广播公司 TBS 用它实现了大型媒体档案的自动元数据标注,极大提高了资料搜索的效率;初创公司 Replit,则用它更高效、更快、更准确地生成、解释和转换代码。

加入音频处理能力

不仅如此,Gemini 1.5 Pro 现在还增加了音频功能。

它能处理音频流,包括语音和视频中的音频。

这直接就无缝打破了文本、图像、音频和视频的边界,一键开启多模态文件之间的无缝分析。

在财报电话会议中,一个模型就能对多种媒介进行转录、搜索、分析、提问了。

Imagen 2.0 能生视频了:4 秒 24 帧 640p

并且,这次谷歌也下场开卷 AI 模型了!

AI 生图工具 Imagen,现在可以生成视频了。

只用文本提示,Imagen 就能创作出实时的动态图像,帧率为每秒 24 帧,分辨率达到 360x640 像素,持续时间为 4 秒。

谷歌表示,Imagen 在处理自然景观、食物图像和动物等主题时,表现尤为出色。

它不仅能够创造出一系列多样的摄影角度和动作,还能确保整个序列的视觉一致性。

同时,这些动态图像也配备了安全过滤和数字水印技术。

图像编辑

并且,谷歌对 Imagen 2.0 也升级了图像编辑功能,增加了图像修复、扩展、数字水印功能。

想把图中这个男人去掉?一键圈出,他就没了!并且模型还自动补全了山上的背景。

想让远处的山高一点?Imagen 2.0 也能轻松做到。

另外,它还可以帮我们扩大图片边缘,获得更广阔的视角。

而数字水印功能,由 Google DeepMind 的 SynthID 强力驱动。

这样,用户为就可以图片和视频生成隐形水印,并且验证它们是否由 Imagen 所生成。

全新代码模型 CodeGemma 发布,核心团队华人占 6 成

最新发布轻量级代码生成模型 CodeGemma,采用的是与 Gemma 系列相同的架构,并进一步在超过 5000 亿个代码 Token 上进行了训练。

目前, CodeGemma 已经全系加入 Vertex AI。

论文地址:https://storage.googleapis.com/deepmind-media/gemma/codegemma_report.pdf

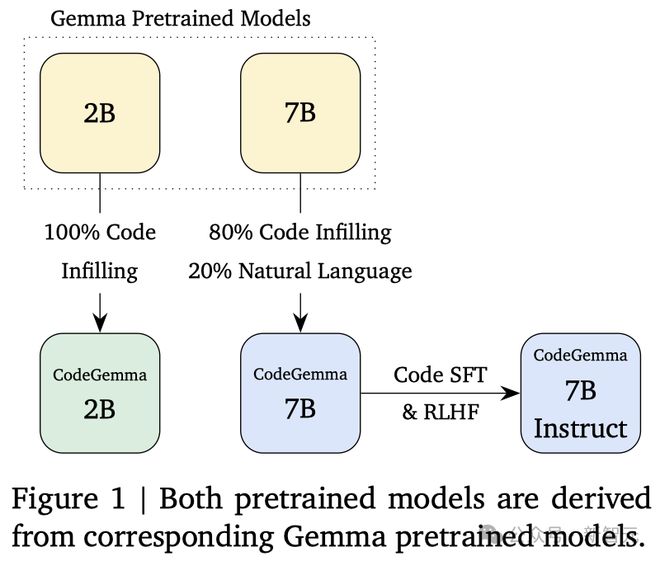

具体来说,CodeGemma 共有三个模型检查点(Checkpoint):

CodeGemma 7B 的预训练版本(PT)和指令微调版本(IT)在理解自然语言方面表现出色,具有出众的数学推理能力,并且在代码生成能力上与其他开源模型不相上下。

CodeGemma 2B 则是一个 SOTA 的代码补全模型,可以进行快速的代码填充和开放式生成。

预训练数据

CodeGemma 的训练数据包括了来自网络文档、数学和代码的 5000 亿个 Token(主要是英文)。

2B 规模的模型完全使用代码进行训练,而 7B 规模的模型则采用了 80% 编程代码外加 20% 自然语言的方式。

为了确保数据的质量,谷歌对数据集进行了去重和过滤,移除了可能影响评估的代码样本和一些个人或敏感信息。

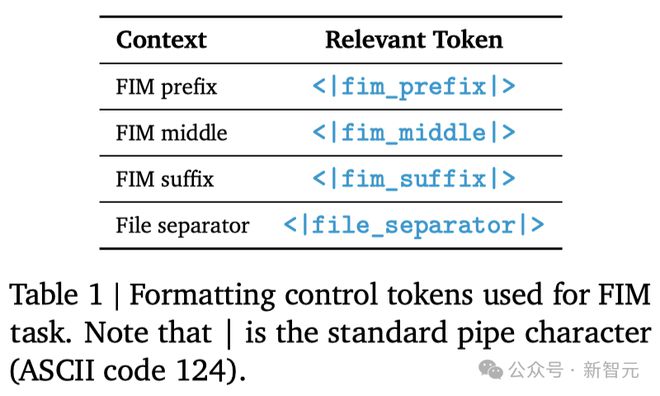

此外,谷歌还对 CodeGemma 模型的预训练采用了一种改进的中间填空(Fill-in-the-Middle, FIM)方法,以此来提升了模型的训练效果。

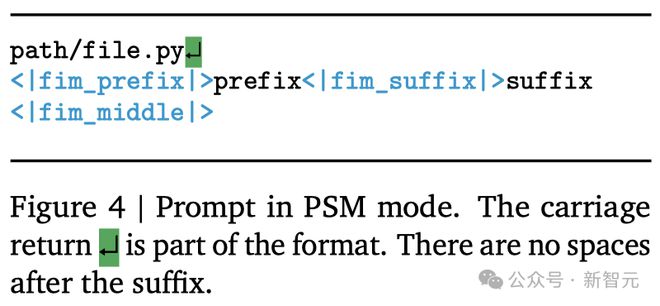

具体可以分为两种模式:PSM(前缀-后缀-中间)和 SPM(后缀-前缀-中间)。

指令微调

通过让模型接触各种数学问题,可以提升它在逻辑推理和解决问题方面的能力,这对编写代码来说是非常重要的。

为此,谷歌选用了多个主流的数学数据集进行监督微调,包括:MATH、GSM8k、MathQA,以及合成数学数据。

在代码方面,谷歌采用了合成代码指令的方法来创建数据集,用于后续的监督微调(SFT)和基于人类反馈的强化学习(RLHF)之中。

为了确保生成的代码指令数据既有用又准确,谷歌采取了以下方法:

- 示例生成:根据 OSS-Instruct 的方法,制作一系列独立的问题与答案对;

- 后期过滤:利用大语言模型来筛选这些问题与答案对,评估它们的实用性和准确性。

代码补全

如表 2 所示,CodeGemma 2B 在代码补全场景下展现出了卓越的性能,尤其是在低延迟的表现上。

其中,推理速度更是比不少模型快了有 2 倍之多。

Python

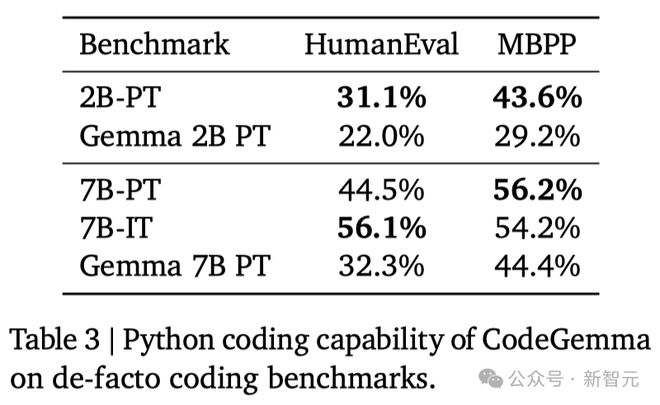

HumanEval 和 Mostly Basic Python Problems 的评估结果如表 3 所示。

与 Gemma 基础模型相比,CodeGemma 在编程领域的任务上表现明显更强。

多种编程语言

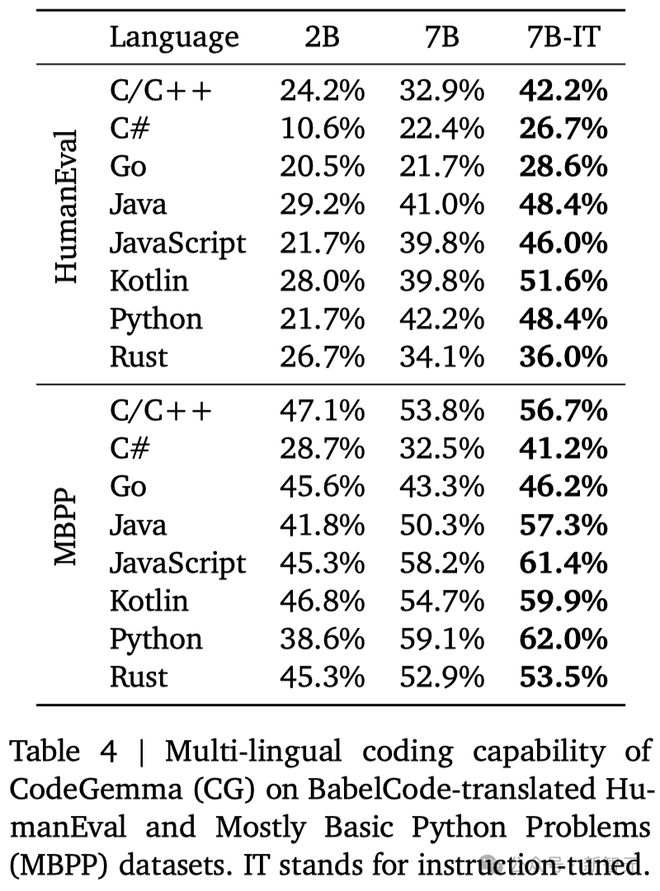

BabelCode 通常用来评估模型在多种编程语言中的代码生成性能,结果如表 4 所示。

语言处理能力

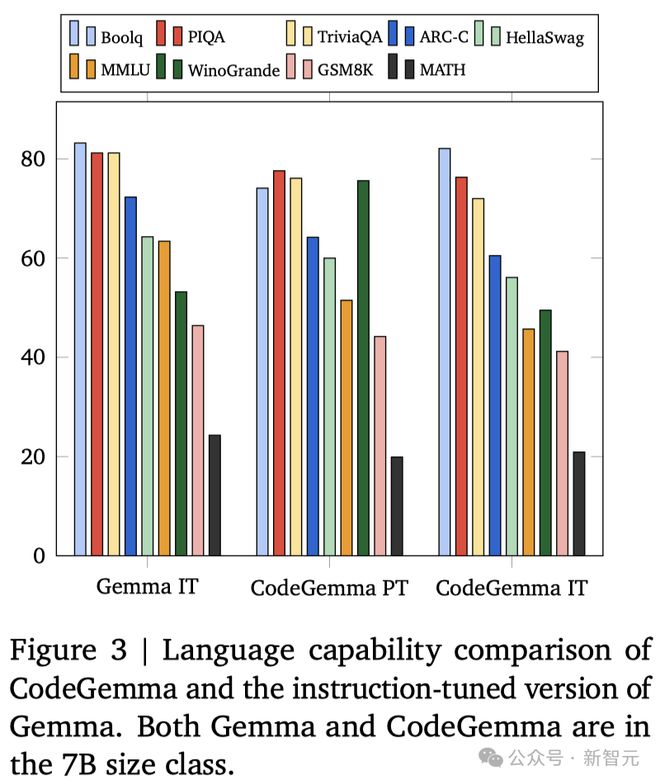

图 3 展示了多个领域的性能评估结果,包括问答、自然语言处理以及数学推理。

可以看到,CodeGemma 同样有着 Gemma 基础模型的自然语言处理能力,其 PT 和 IT 版本在性能上均优于 Mistral 7B 和 Llama2 13B——分别领先了 7.2% 和 19.1%。

进一步地,如表 5 所示,CodeGemma 在数学推理方面,相比同等规模的模型有着更出色的表现。

推理建议

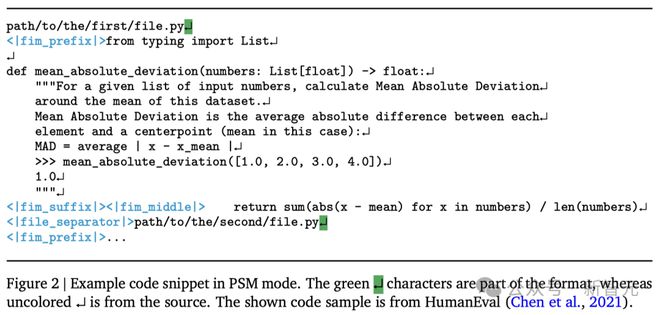

如图 4 所示,在进行代码补全任务时,比如函数补全、注释文档字符串生成或者导入模块建议,应当按照一定的格式来设计输入提示。

官宣自研 Arm 架构 CPU 处理器 Axion

此次 Next 大会上,谷歌还正式宣布,将自研首款基于 Arm 的 CPU。

据称这款 CPU 处理器 Axion,将提供比英特尔 CPU 更好的性能和能源的效率,其中性能提高 50%,能源效率提高 60%。

据悉,比起目前基于 Arm 的最快通用芯片,Axion 的性能还要高出 30%。

凭着这个新武器,谷歌也在 AI 军备竞赛中,正式向微软和亚马逊宣战!

新 CPU Axion,显然是谷歌跟随亚马逊 AWS 和微软 Azure 的动作——它也想自研处理器了。

Axion 将帮助谷歌提高通用工作负载的性能,比如开源数据库、Web 和应用程序服务器、内存缓存、数据分析引擎、媒体处理和 AI 训练。

由此,谷歌在开发新的计算资源方面,又向前迈进了一步。在今年晚些时候,Axion 就可用于云服务了。

AI 军备竞赛加快,CPU 重要性凸显

对于 AI 军备竞赛来说,像 Axion 这样的 CPU 至关重要,因为它能提升训练 AI 模型所需的算力。

要训练复杂的 AI 模型,就需要处理大型数据集,而 CPU 有助于更快地运行这些数据集。

要说此举的最大的好处,那无疑就是——省钱!

众所周知,购买 AI 芯片的成本惊人,英伟达的 Backwell 芯片,预计售价在 3 万美元到 4 万美元之间。

现在,Axion 芯片已经在为 YouTube 广告、Google Earth 引擎提供加持了。

而且,很快就可以在谷歌计算引擎、谷歌 Kubernetes 引擎、Dataproc、Dataflow、Cloud Batch 等云服务中使用。

不仅如此,原本在使用 Arm 的客户,无需重新架构或者重写应用程序就可以轻松地迁移到 Axion 上来。

TPU v5p 上线,与英伟达合作加速 AI 开发

在此次 Google Cloud Next 2024 年会上,谷歌宣布:对自家超算平台进行大规模升级!

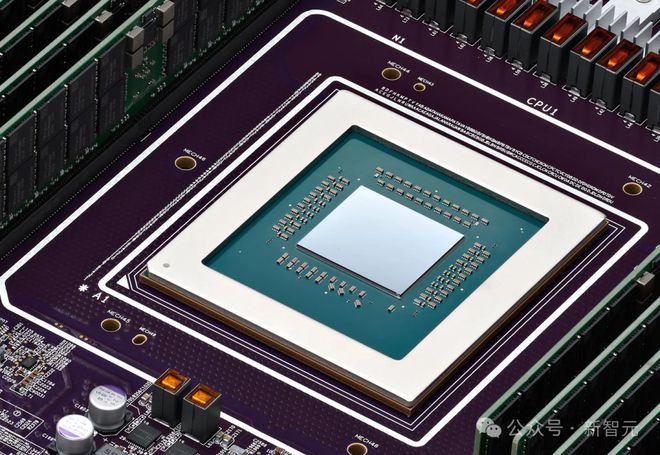

升级列表中的第一位,就是谷歌云的张量处理单元 TPU v5p 了。如今,该定制芯片全面向云客户开放。

谷歌的 TPU,一直被用作英伟达 GPU 的替代品,用于 AI 加速任务。

作为下一代加速器,TPU v5p 专门用于训练一些最大、最苛刻的生成式 AI 模型。其中,单个 TPU v5p pod 包含8,960 个芯片,是 TPU v4 pod 芯片数量的两倍之多。

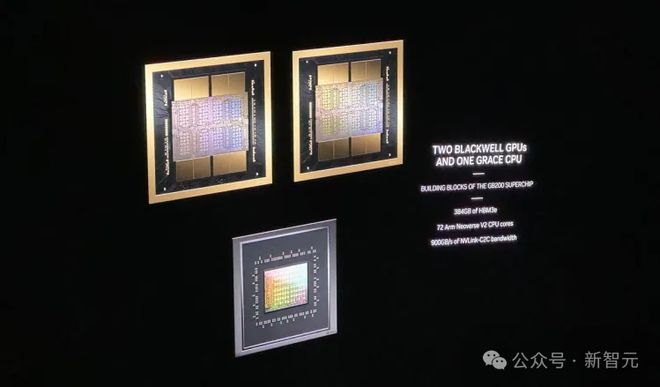

另外,谷歌云还将和英伟达合作加速 AI 开发——推出配备 H100 的全新 A3 Mega VM 虚拟机,单芯片搭载高达 800 亿个晶体管。

而且谷歌云还会将英伟达最新核弹 Blackwell 整合进产品中,增强对高性能计算和 AI 工作负载的支持,尤其是以 B200 和 GB200 提供支持的虚拟机形式。

其中,B200 专为「最苛刻的 AI、数据分析和 HPC 工作负载而设计」。

而配备液冷的 GB200,将为万亿参数模型的实时 LLM 推理和大规模训练提供算力。

虽然现在万亿参数的模型还不多(少量几个选手是 SambaNova 和谷歌的 Switch Transformer),但英伟达和 Cerebras 都在冲万亿参数模型硬件了。

显然,他们已经预见到,AI 模型的规模还会迅速扩大。

软件

在软件方面,谷歌云推出了 JetStream,这是一款针对 LLM 的吞吐量和内存优化了的推理引擎。

这个新工具可以提高开源模型的单位美元性能,并与 JAX 和 PyTorch/XLA 框架兼容,从而降本增效。

存储大战

此外,谷歌的存储解决方案也在不断升级——不仅加速了 AI 训练和微调,优化了 GPU 和 TPU 的使用,还提高了能效和成本效益。

此次,谷歌推出的 Hyperdisk ML,显著缩短了模型加载时间,提高了吞吐量,并对 AI 推理和服务工作负载进行了优化。

不仅支持每个存储卷承载2,500 个实例,而且还提供了高达 1.2TiB/s的数据吞吐量,性能直接超越微软和 AWS。

已发布的 Cloud Storage FUSE,可将基础模型的训练吞吐量提高 2.9 倍,性能提高 2.2 倍。

高性能并行文件系统 Parallelstore 可将训练速度提高到 3.9 倍,并将训练吞吐量提高到 3.7 倍。

而专为 AI 模型量身定制的 Filestore 系统,允许在集群中的所有 GPU 和 TPU 之间同时访问数据,将训练时间缩短 56%。

总之,此次谷歌超算的大规模更新表明,谷歌在努力为客户带来实际的商业利益,创建无缝集成、高效可扩展的 AI 训练和推理环境。

参考资料:

https://storage.googleapis.com/deepmind-media/gemma/codegemma_report.pdf

https://www.businessinsider.com/google-ramped-up-ai-competition-against-microsoft-amazon-2024-4

https://www.theverge.com/2024/4/9/24125074/google-axion-arm-cpu-ai-chips-cloud-server-data-center

https://blogs.nvidia.com/blog/nvidia-google-cloud-ai-development/

https://venturebeat.com/ai/google-upgrades-its-ai-hypercomputer-for-enterprise-use-at-cloud-next/